22年末頃から話題となったChatGPTは、個人や企業においてさまざまな使い方が紹介されています、最近、さらに機能が進化したAuto-GPTが登場しました。この新しいツールは自律型AIエージェント(事前に定義された目標を達成するためのコードまたはメカニズム)という領域に進もうとしています。Auto-GPTは、一言でいえば、大規模言語モデル(LLM)が人による入力作業なしにタスクを考え、計画、実行するというツールです。ChatGPTから独立した姉妹版とも言えます。

Auto-GPTは、AGI(Artificial General Intelligence:汎用人工知能=人間と同様の感性や思考回路を持つAI)の前哨との声も上がっています。今回は、Auto-GPTの機能と仕組み、課題、特徴、代替オプションなどについて解説します。

AIの未来を信じますか?

Telegramで暗号資産愛好家のBeInCrypto Trading Communityに参加してください: 暗号通貨や分散型システムについて学び、無料の基礎コースで取引をスタートさせ、プロのトレーダーとトレンドについて語り合いましょう!

Auto-GPTとは?

Auto-GPTは、自律性に重点を置いたAIアシスタントです。GPT-4、GPT-3.5をバージョンアップさせたインターフェースで、人の手を必要とせず、自立的にタスクを実行できます。特定のプロンプト(質問)が必要なChatGPTとは異なり、Auto-GPTは、ユーザーが設定したタスクを完遂するために自らプロンプトを生成し、監督します。

Auto-GPTはChatGPTと何が違うのかについては、こう考えてみてください。

ChatGPTのようなAIチャットボットの力を真に引き出すには、適切なクエリ(質問)を投げかける必要があります。つまり、AIチャットボットのアウトプットの質は、ユーザーが与えるプロンプトの質に大きく依存します。しかし、そのような手間をかけずに、アプリに自ら最適なプロンプトを見つけさせることができたらどうでしょう。そして、さらに一歩進んで、その後のステップと実行方法を考えさせ、作業が完了するまでプロセスを繰り返させたらどうでしょうか。そこがAuto-GPTの目指すところなのです。

その目指す先には、知能だけでなく、臨機応変な対応力も必要です。Auto-GPTは、ウェブサイトや検索エンジンにアクセスしてデータを収集します。そして、ここで重要なのはそのデータの品質をAI自身で評価できることです。Auto-GPTは、基準に満たないものは切り捨て、最初からやり直してより良いデータを見つけるために新しいサブタスクを作成します。このようにして、Auto-GPTは自律的なAIエージェントとしての実績を上げていきます。

もし、Auto-GPTを実際に試してみたいのであれば、有料のOpenAIアカウントが必要です。そして、OpenAIのAPIを入手することになりますが、これはAuto-GPTがOpenAIのGPT-4やChatGPTとやりとりする際の橋渡しの役割を果たします。

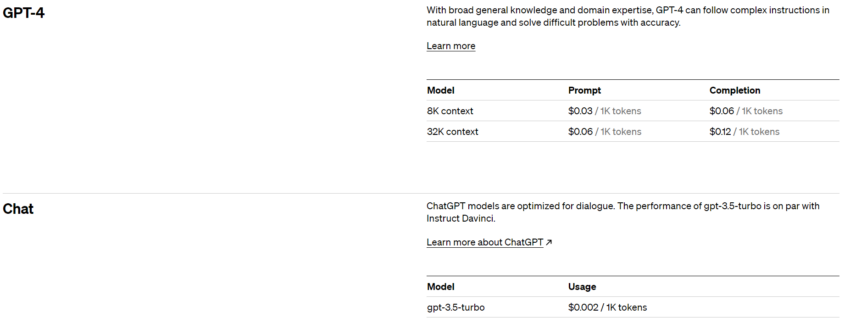

Auto-GPTの使用にかかるコストについては、OpenAIのトークン(ワードを単位とした通貨)ですべて表されます。1トークンはおよそ4文字、0.75ワードに相当します。総費用は、ユーザーが送受信するプロンプトにかかるトークン数によって決まります。

Auto-GPTの利用方法

Auto-GPTをセットアップするには、OpenAIのアカウントにログインし、基本的なステップを踏むことで簡単にアクセスできるChatGPTとは異なり、以下のような少し複雑な手順が必要です:

- ステップ 1:まず、操作に必要なPython 3.8(以降バージョン)、OpenAI APIキーを用意します。これらのダウンロードはAuto-GPTのGitHubページを参照。

- ステップ 2:上記ツールをインストールしたらGitHubウェブサイトにアクセスして「Code」をクリックし、Zipファイルをダウンロードする。左側にある(プルダウンメニューの)「Stable」ブランチを選択する。「Master」は少し不安定との表示がある。【同画面下方の「USE stable not master(masterではなくstableを使用)」を参照】

- ステップ 3:(Windowsの)Power Shellを開き、次のコードを実行する:git clone https://github.com/Torantulino/Auto-GPT.git’.(画面下方に参照デモ動画あり)

- ステップ4:次に、(コマンド上で)「cd Auto-GPT」のプロジェクトディレクトリに移動する。

- ステップ 5:正しい場所に移動したら、次のコマンドでライブラリーをインストールする: 「pip install -r requirements.txt」

- ステップ 6:最後に、「env. template」を「.env」にリネームし、自分のOPENAI_API_KEYを入力する。

以上でAuto-GPTを使用する準備が整いました。自分のボットに名前をつけて、利用してみましょう。

OpenAI APIについては、8,000コンテキストと32,000コンテキストの2つのオプションが選択できます。下の画像のように、価格はユーザーが選択するモデルによって、かなり高額になる場合があるので注意してください。これらのデメリットについては、この記事の後半で詳しく説明します。

ユーザーは、コストについては過度に心配する必要はありません。ユーザーはAPIにいくら使うか、ソフトとハードの両面から支出制限を設定できます。ソフトリミットを設定した場合、OpenAIは設定した(トークン数の)リミットに達したことを知らせるメールをユーザー宛てに送信します。また、ハードリミットの場合は、より効率的に、(トークン数が)制限に達するとOpenAIがすべてのAPI関連サービスを自動的に終了させます。

大規模言語モデル(LLM)における「コンテキスト」とは?

ここでいう「コンテキスト」とは、言語モデルが応答を生成するために使用する先行テキストまたは情報のことです。例えば人が会話の中で、何を言われたかを覚えておくと、それに応じた返答ができるように、GPT-4や他の言語モデルもそのような仕組みでできています。GPT-4などの言語モデルは、「コンテキスト」と呼ばれる、過去のすべてのテキストを利用して、次に何を言うべきかを考えます。

例えば、会話の最後の2文しか覚えていないとします。これでは、かなり(応答するのに)限界があります。そこで、AIモデルには「コンテキストウィンドウ」という、短期間の保存メモリのようなものがあります。

2023年5月現在、GPT-4はテキストで25,000語以上のワードを扱うことができ、それ以前にGPTモデルが提供してきた「コンテキスト」よりもはるかに長くなっています。

Sponsored SponsoredAuto-GPTの仕組みについて

Auto-GPTは、優秀なAIアシスタントと考えてください。ミッションを与えると、それを達成するためのロードマップを作成します。Auto-GPTは、インターネット閲覧やデータ抽出などのタスクであれば、ミッションが達成されるまで戦略を練り直します。

それは、市場分析やカスタマーサービス、ファイナンスなど、様々なタスクをこなすパーソナルアシスタントのようなものです。

Auto-GPTを動かしている中核は以下の4つの部分です:

- アーキテクチャ:認識エンジンとしてGPT-4とGPT-3.5の強味を活用し、思考や問題解決を図る。

- 自律的な能力:自己改善メカニズムを持つ。自身のパフォーマンスを振り返り、経験を活かし、より正確な結果を出すために過去の履歴を利用する。

- メモリ管理:記憶装置であるベクターデータベースと連携して、コンテキストを保持し、多くの情報に基づいた判断を下す。ボットの長期記憶アーカイブに類似。

- 多機能性:ファイル操作、ウェブ閲覧、データ収集など、従来のAIから飛躍的に進化した多次元的な機能の保有。

Auto-GPTは基本的に、AIとLLMを活用して膨大なタスクを処理し、過去から学び、継続的にパフォーマンスを向上させる、物理的な形状を持たないロボットといえます。

一方、Auto-GPTのこのような魅力的な潜在能力は、その真の実力をまだ十分に反映していないともいえます。そこで、(そうした能力を妨げている)Auto-GPTが現在直面している限界と課題について、以下に手短に説明します。

Auto-GPTのデメリット

コストの問題

Auto-GPTの中核を成すGPT-4の利用には、かなりコストがかかります。ユーザーに対しては、タスクシーケンス内の「認識」ステップごとに、GPT-4の演繹(えんえき)的処理とフォローアッププロンプト(同じ会話内の以前のプロンプトへの質問やリクエストなど) のためのトークン費用が発生します。

ユーザーが8Kのコンテクストウィンドウ(約13ページの文章)を使用した場合、プロンプトにかかる入力コストは1,000トークンあたり0.03ドル、出力コスト(完成時)は1,000トークンあたり0.06ドルになります。コンテキストウィンドウを最大限に活用し、プロンプトを80%、出力を20%に配分すると、各認識ステップで0.288ドルのコストが発生します。

平均的な単純作業を行なうだけでも、50ステップ(あるいはそれ以上)が必要になります。つまり、比較的単純なタスク1つでも、(0.288ドル×50=)14.40ドルの費用がかかることになります。このように、現在Auto-GPTの運用はコスト高であるため、利用を考えているユーザーや企業の多くにとっては経済的に手が届かないものになっています。

「頻繁に起きるループ」問題

ユーザーは、Auto-GPTでワークフローを整理し、タスクをうまくこなせるのであれば、OpenAIのAPI使用料は正当な支出だと思うかもしれません。しかし、それは必ずしもそうとは言い切れません。

Sponsoredr/autogptのようなsubreddit(「掲示板」におけるスレッド)や類似のプロンプトをフォーラムをチェックすると、Auto-GPTがよく途中で立ち止まると訴えるユーザーが大勢見られます。利用したことのある人でも、Auto-GPTは期待されたソリューションを生み出す前に、処理のループ(理想的な成果が出るまで繰り返す状態)に陥ることがよくあります。

Auto-GPTは、その高度な機能に反して、提供される機能が少ないことやGPT-4の推論能力の未熟さによって、問題解決の範囲が限られているのが現状です。

Auto-GPTのソースコードは、Web検索、メモリ操作、ファイル交換、コード実行、画像生成など機能が限られており、対応できるタスクの範囲に制約があります。また、GPT-4は以前の機種に比べて改善されているものの、推論能力はまだ理想にはほど遠い状況です。そのため、ソリューションまで至らず、ループしてしまうケースが少なくありません。

Auto-GPTのアプリケーション

Auto-GPTは、ChatGPTのような「通常の」AIチャットボットの枠を超えた存在です。例えば、ソフトウェアアプリケーションの開発全体を監督し、実行に移す能力があります。また、ビジネスや経営の分野では、企業の業務を精査し、洞察に富んだ改善案を提示して、企業価値の自律的な向上を図ることもできます。

Auto-GPTはインターネットにアクセスできるため、指定した条件に基づいて市場調査や製品比較などのタスクを実行できます。自分で改善していく能力もあるため、自身のコードの更新を作成、評価、レビュー、テストでき、効率と機能の向上が期待できます。また、優れたLLMの作成プロセスを促進し、次世代のAIエージェントの土台となる見込みもあります。

Auto-GPTのアプリケーションのまとめ

世界中のユーザーは、ポッドキャストの作成、株式分析から、ソフトウェアの制作、多くのAIボットの開発まで、分野を問わずAuto-GPTを創造的な用途に活用しようとしています。Auto-GPTの最も一般的なアプリケーションには、以下のようなものがあります(ただし、それらに限定されません):

- ウェブサイトの制作

- 最小限の入力でブログ・記事を作成

- 効果的なマーケティング戦略の立案

- 製品や書籍のレビューなど、ユーザーとの相互交流の自動化

- DALL-E 2やMidjourneyなどのAI画像ジェネレーターを使用したグラフィックデザインやビジネスロゴの作成

- 会話型インターフェースやチャットボットの開発

Auto-GPTと他AIエージェントの比較

Auto-GPTは、唯一無二の自律型AIエージェントではありません。ほかにもたくさんあり、それぞれに魅力と限界があります。以下は、Auto-GPTの代替として最も人気のある3つのツールです:

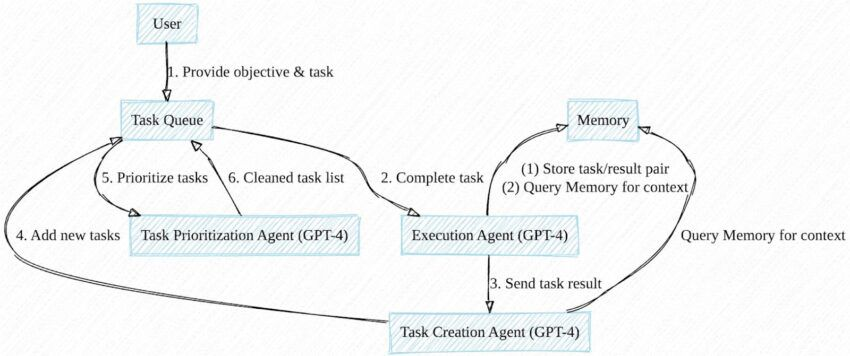

Sponsored SponsoredBabyAGI

Auto-GPTと同じく、中島洋平氏が考案したBabyAGIもGitHubで公開されています。BabyAGIは、設定された目的に沿ったタスクを自動生成し、優先順位をつけて実行します。このツールにアクセスし使用するには、Dockerソフトウェアと、OpenAIまたはPineconeのAPIキーが必要となります。

BabyAGIの中心は、タスクリストと連動する言語モデルです。完了したタスクはデータベースに保存され、新しいタスクを作成・実行する際のコンテキストのための「記憶」となります。ベースとなるスクリプト(ひな形)には、インターネット調査や自律的なコード実行の機能はありませんが、派生バージョンでは導入されています。

Microsoft JARVIS

Microsoft JARVISは、HuggingGPTとしても知られ、OpenAIのGPTモデルがコントローラーとして機能するマルチAIモデルシステムです。

JARVISは、画像、動画、音声などを処理する様々なオープンソースモデルを組み込んでいます。インターネットに接続し、各種ファイルへのアクセスもできます。また、BabyAGIやAuto-GPTと同様に、タスクを評価し、最適なモデルを選択して完了に至ります。

AgentGPT

AgentGPTは、Auto-GPT/BabyAGIのコンセプトをWebベースで拡張したものです。使用説明書に従ってブラウザから自律型エージェントを起動できます。

AgentGPTの特徴(最終更新日時点)は、以下の通りです:

- データベースのバックアップによる長期メモリ

- ウェブ閲覧とウェブサイトや個人との交流

- エージェント実行(記録)の保存

Auto-GPTがAIの未来に与える影響

Auto-GPTや類似のエージェントは、AIの進化における次のフェーズを担っていくと思われます。今後、より工夫、洗練された、多彩かつ実用的なAIツールが登場するとみられます。こうした進化は、私たちの仕事、レジャー、コミュニケーションのあり方を大きく変える可能性を秘めています。しかし一方で、こうした高い潜在能力があっても、生成AIに内在する課題の解決には結びついていません。現在の課題は、出力精度の不安定さから、知的財産権の侵害の可能性、さらにAIを悪用して偏ったコンテンツや有害なコンテンツを流布する可能性まで、多岐にわたっています。

AIエージェントがスーパーインテリジェンスの域まで進化する脅威については、物理学者でベストセラー作家のマックス・テグマーク氏が2017年に出版した『Life 3.0』で、その可能性についてごく簡潔に言及しています。

「本当の心配は(使う側の)悪意ではなくて、それが持つ能力だ。スーパーインテリジェントなAIは、定義上、対象が何であっても非常に優れた能力を発揮して目標を達成できるため、そうした目標が私たちのそれと一致するよう確認していく必要がある」

私たちは、これからの未来に向けてどういう目標を立てて、Auto-GPTを適切に使用していくかが最も問われているのかもしれません。